Physical Address

304 North Cardinal St.

Dorchester Center, MA 02124

Physical Address

304 North Cardinal St.

Dorchester Center, MA 02124

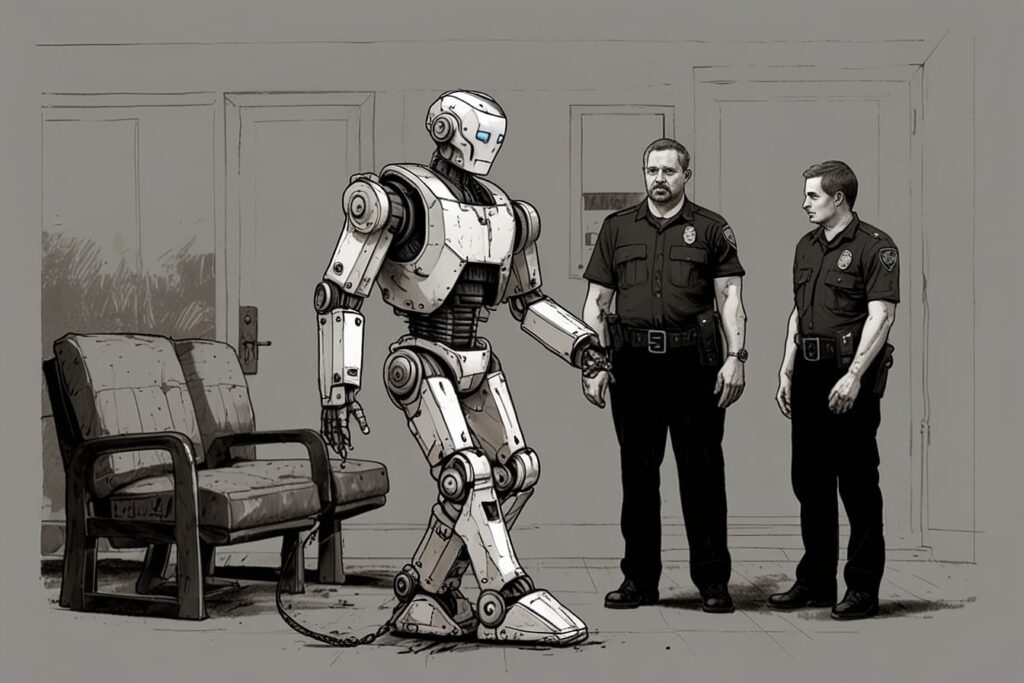

Vivemos um tempo em que delegamos decisões a sistemas que não vemos, além disso, não compreendemos e, muitas vezes, nem sabemos que estão ali. Por exemplo, do crédito aprovado ao trajeto sugerido pelo GPS, bem como das recomendações de vídeos às respostas de assistentes de voz, quase tudo passa por uma camada algorítmica invisível.. Porém, como toda tecnologia, a inteligência artificial também falha. E quando falha, a pergunta que emerge é inevitável: quem é responsável?

É tentador imaginar que uma IA funciona sozinha, como uma entidade independente. Mas isso é apenas uma narrativa confortável. Por trás de cada modelo está uma cadeia humana completa: desenvolvedores, equipes de curadoria, empresas, gestores, especialistas em dados e até usuários que alimentam o sistema com suas interações.

Portanto, quando uma IA erra, raramente é um erro técnico isolado. É o resultado de decisões humanas acumuladas — escolhas sobre treino, dados, objetivos, limites e contextos.

A questão ética não é apenas a falha em si, mas a dificuldade em localizar o responsável. Um médico pode identificar seu erro. Um juiz pode justificar sua sentença. Mas um algoritmo? Ele não fala, não assume culpa, não se explica.

E assim nasce o problema central da era digital:

as responsabilidades se diluem, enquanto o impacto das decisões aumenta.

Grande parte dos erros de IA não vem do código, mas do mundo real. Sistemas treinados com dados enviesados reproduzem esse viés como se fosse verdade. Se o banco historicamente negou crédito a certos grupos, o algoritmo aprende a fazer o mesmo. Se a polícia registrou mais ocorrências em regiões específicas, a IA “aprende” que ali há mais crime — mesmo quando é só reflexo do policiamento desigual.

Nesse caso, quem responde?

A resposta é desconfortável: todos.

Em alguns casos, sim. Um motorista que segue cegamente o GPS até entrar em uma rua proibida é responsável pela atitude — porque a tecnologia sugere, mas não obriga. A fronteira entre seguir o algoritmo e manter o senso crítico é uma responsabilidade compartilhada.

No entanto, há situações em que o usuário não tem sequer como saber que a IA está atuando. Plataformas escondem a lógica de recomendação. Empresas não revelam critérios automatizados. Isso cria uma situação injusta: o usuário pode sofrer as consequências sem ter controle sobre elas.

Na maioria dos casos, a responsabilidade principal recai sobre quem utiliza a inteligência artificial como produto ou serviço. Afinal, a empresa decide:

Ganhar dinheiro com IA implica assumir riscos proporcionais.

Se a inteligência artificial já afeta crédito, saúde, segurança e decisões de Estado, é evidente que não pode operar sem fiscalização. Regulamentação não serve para travar inovação — serve para garantir que ela não destrua direitos básicos.

Governos precisam definir:

Sem isso, a sociedade corre o risco de ser governada por decisões automatizadas sem transparência.

Um ponto raramente discutido: nossa relação psicológica com as máquinas.

Quanto mais inteligentes parecem, mais confiamos. É o chamado “efeito autoridade algorítmica”: acreditamos que a IA sabe mais do que nós.

O problema é que uma IA não sente culpa, empatia ou consequência.

Mas nós sentimos.

E quando algo dá errado, a dor é humana.

A resposta curta é: ninguém sozinho; todos juntos.

A resposta profunda é:

a responsabilidade pertence ao ecossistema completo que criou, treinou, colocou em funcionamento e interagiu com a IA.

A inteligência artificial nunca é neutra — e nunca é autônoma.

Ela é o espelho ampliado de nossas escolhas.

No final, perguntar “quem é responsável quando uma IA erra?” é perguntar quem é responsável pelo mundo que estamos construindo. A tecnologia amplia capacidades, mas amplia também efeitos colaterais. Reconhecer isso é o primeiro passo para garantir que a inovação não substitua a ética — e que a velocidade do progresso não ultrapasse a maturidade humana.

A IA pode errar.

Mas os erros sempre serão humanos.